上周,在机器学习国际会议上,研究人员展示了一只3D打印的海龟。当会上的大多数人都认为它确实是一只乌龟的时候,人工智能算法得到的答案却是不同的。大多数的人工智能都认为这只乌龟看上去像一支步枪。同样,它也会错把3D打印的棒球看作一种浓缩咖啡。

这些都是“对抗性攻击”的例子。

“对抗性攻击”是指通过改变一些不易察觉的元素(图像、物体或是声音)来欺骗人工智能识别算法,使其无法正确识别图像或物体,而这种愚弄方式连人类也不能轻易察觉。

近几年,人工智能取得了极大的进展,尤其是在消化训练数据集之后能够识别声音或物体的机器学习算法,AI的进步同时也刺激了客厅语音助理和自动驾驶汽车的发展。

但令人惊讶的是,这些人工智能很容易被欺骗。在这次会议上,“对抗性攻击”是一个热门话题,研究人员们在会议上汇报了一些新颖的用来欺骗人工智能的算法以及防御这种攻击的有效手段。

这次会议的其中一个奖项颁给了一项消极研究,该研究表明受保护的人工智能并不像开发者想象的那么安全。 剑桥麻省理工学院(MIT)的计算机科学家Anish Athalye表示:”在机器学习领域,我们只是不习惯从安全的角度来思考这个问题。”

研究对抗性攻击的计算机科学家表示他们提供一种服务,就像黑客可以找出软件安全漏洞一样。“我们需要重新考虑我们所有的机器学习途径,使其更加安全。” 麻省理工学院计算机科学家 Aleksander Madry 表示。研究人员认为这种类型的攻击在科学上也是有用的,它为AI提供了一个罕见的窗口,也就是神经网络。加利福尼亚大学伯克利分校的计算机科学家 Dawn Song 说:“这些攻击就像是一面镜子,通过它我们可以加深对机器学习的了解。”

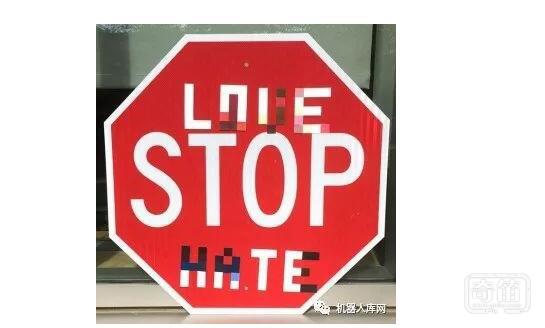

这些攻击严重在它们是不易被察觉的。去年,Song和他的同事在一个停车标志上贴了一些小标签,结果一个图像识别AI算法系统把它当作一个每小时45英里的限速标识,这一结果无疑让自动驾驶汽车公司不寒而栗。

其中一些对抗性攻击利用对目标算法内部结构的了解进行攻击,这就是所谓的白盒攻击。例如,如果攻击者研究出来某个人工智能的“梯度”(它描述了输入图像或声音的轻微变化如何将输出移动到预测的方向),那么他就可以计算出如何一点一点地改变输入以获得所需的错误输出—比如说一个”步枪”的标签–而不需要以改变输入图像或声音等显眼的方式来迷惑AI。

人工智能开发者不断地加强他们的防御系统。其中一项技术是将图像压缩作为图像识别AI的一个步骤。这就给算法中平滑的梯度增加了锯齿效果,从而使攻击者难以识别算法梯度。然而在这场猫捉老鼠的游戏中,这种“梯度模糊处理”的方法已经被破解了。在ICML的一篇获奖论文中,Carlini,Athalye 和一位同事分析了最近的人工智能会议中的九种图像识别算法。 其中有7个算法将梯度模糊处理作为一种防御机制,然而团队通过避开图像压缩等方法成功破解了这7个算法。Carlini说,几乎所有黑客都能在几天内轻松破解这些算法。

一个更强有力的方法是训练一种有某些约束的算法,以一种可检验的数学方法来防止它被对抗性攻击侵害。 Deepmind 驻伦敦的计算机科学家Pushmeet Kohli表示:”如果你能找到这种方法,游戏就结束了。” 但是这些可验证的防御系统到目前为止还没有扩展到现代人工智能系统中的大型神经网络。Kohli表示,这些系统有扩展的潜力,但是研究人员担心它们将会受到现实世界的限制。 “例如行人是无法用数学方法来定义的,” Song说,”那么我们如何证明自动驾驶汽车不会撞上行人呢?”

Carlini希望开发人员能够更加努力地思考这些算法的防御系统如何更有效以及它们为何会失败,而不仅仅是关心它们在平常的基准测试中表现是否良好。他表示:“缺乏严谨性给我们的研究带来很大的伤害。”